Letztes Update: 14. Juli 2025, 23:48h

Wie auf der Hauptseite beschrieben, können Sie eines der unten genannten Themen auswählen; es ist aber auch möglich, eigene Vorschläge einzubringen (dies bitte möglichst bereits in der Vorbesprechung diskutieren/absprechen).

Um ein Thema (verbindlich!) zu wählen, posten Sie den Namen des Papers in den Teams-Kanal “Themenauswahl”. Schauen Sie dort vorher nach, ob das Thema schon vergeben wurde. Falls Sie einen eigenen Vorschlag machen möchten, besprechen Sie dies bitte zunächst mit uns in den entsprechenden Treffen. Themen grundsätzlich first-come-first-served vergeben.

Seminarvorträge

Jedes Thema besteht aus ein oder mehreren Papers. Aufgabe für das Seminar ist es, die wichtigen / interessanten Inhalte diese Papers wiederzugeben. Die Entscheidung darüber, was besonders betont werden soll, liegt dabei bei den Studierenden, die das Thema bearbeiten. Teil der Bewertung ist dabei natürlich auch, wie gut diese Auswahl gelungen ist (hat man wirklich entscheidende Aspekte verstanden und gut vermittelt?). Ein Fokus auf eine Teilmenge der Inhalte ist dabei fast immer notwendig.

Für jedes Thema ist auch angegeben, ob es für B.Sc., M.Sc. oder beides (dann mit höheren Erwartungen im Master) geeignet ist. M.Sc. Themen sind immer auch für B.Sc. Studierende (auf freiwilliger Basis; sollten B.Sc. Themen fehlen, bitte Bescheid geben) zulässig.

Experimente für Seminarvortrag und Ausarbeitung

Dieses Semester ist der experimentelle Teil optional. Sie haben grundsätzlich zwei Möglichkeiten:

Wenn nur die Originalquellen zusammengefasst werden, muss die Ausarbeitung ausführlicher sein als wenn eigene Experimente gemacht werden (ca. 2x so viel Umfang). Bei einer experimentellen Ausarbeitung sollten die Originalquelle auch ganz kurz beschrieben werden; dies ist aber nicht der Hauptfokus.

Details siehe hier.

Hinweis: Die Themenliste wurde am 14. Juli 2025 früh morgens (1:30am) online bereit gestellt.

Es gibt vier Teilbereiche. Je nachdem mit welcher Vorlesung das Seminar im Modulkonzept kombiniert werden soll, sollte ein passendes Thema gewählt werden (Abweichungen bitte unbedingt vorher absprechen!):

Mod-1 – Modellierung 1: Arbeiten zu grundlegenden Modellierungstechniken (passend zu "Modellierung 1 - lineare Modelle)DL – Deep Learning / Modellierung 2: Theoretische(re) Arbeiten zu statistisches Lernen mit tiefen Netzwerken. Passend zu “Deep Learning Theorie und Praxis” (oder Vorgängervorlesungen)2D-CV/3D-CV – Computer-Vision: Aktuelle Arbeiten aus der Computer-Vision. Passend zu den 2D/3D Computer-Vision Veranstaltung von Prof. Schwanecke. Grundsätzlich sind die Themen für beide Vorlesungen geeignet (2D/3D wird nicht formal für die Modulzuordnung unterschieden, das ganze dient nur als Hinweis).Einige der Themen passen zu mehreren Themengebieten; dies ist entsprechend markiert.

Level: Bachelor/Master

Gebiet: 3D-CV

Paper:

Thema: NERFS (Neural Radiance Fields) haben viel Aufmerksamkeit erregt. Wie sich herausstellt, kann man NERFs auch ohne Deep Learning (ohne Neural) machen. Also von NERFs zu ’RFs, sozusagen. Fitting von Voxeln mit Spherical Harmonics (Graphikern nicht unbekannt) reicht.

Warum diese Thema? Das Ende eines jungen Klassikers – NERFs braucht man gar nicht? Alles nur Snake-Oil? Read to find out more!

Praktische Aufgabe: “Neural Fields”-Aufgabe, siehe unten.

Schwierigkeit: Moderat; Grundkenntnisse in Computergraphik sind nötig.

Level: Bachelor/Master

Gebiete: 3D-CV, Mod-1

Paper:

Thema: Dieses Paper beschreibt, wie man direkt 3D Geometrie (Meshes) an Bilder (Multi-View-Stereo) anpassen kann, in dem man einfach per Gradientenabstieg Geometrie und Abstrahlung optimiert. Eigentlich galt das immer als unmöglich, da das Problem zu viele lokale Minima hat. Mit einem guten Regularisierer schreint es aber zu klappen.

Warum diese Thema? Sehr schön aufbereitete Arbeit die eindrucksvoll zeigt, dass Regularisierung von inversen Problemen nicht unwichtig ist. :-) Tolle Ergebnisse.

Schwierigkeit: Das vorgestellte System ist durchaus recht komplex, aber es gibt wenig schwarze Magie (weired-math).

Praktische Aufgabe: Code ist verfügbar, aber es ist nicht klar, wie realistisch aufwendigere Experimente sind, da die Methode komplex und aufwendig ist.

Level: Bachelor/Master

Gebiete: 2D-CV

Paper:

Inhalt: Das Paper zeigt, das Probleme bei der Interpretierbarkeit von DNNs auch schlichtweg an der Zielfunktion liegen können; eigentlich funktionieren auch einfache Methoden ganz gut (z.B. bei Self-Supervised Pretraining wie in Thema CV-2). Wieder ein mysteriöses Problem gelöst, mit einer ganz einfachen und einleuchtenden Erklärung.

Aufgabe: Erklären Sie die Kernideen aus dem (Konferenz-) Paper.

Praktische Aufgabe: Code ist verfügbar – man kann damit experimentieren.

Level: Master

Gebiete: DL

Paper:

Inhalt: Das Paper nutzt äußere Produkte von Gradienten als Modell um zu erklären, welche Features ein DNN lernt.

Schwierigkeit: Die Mathematik ist nicht besonders schwer zu verstehen. Die Herausforderung liegt eher darin, nachzuvollziehen, was das ganze Modell für einen Nutzen hat. Das ist auch beim zweiten Lesen nicht sofort klar.

Aufgabe: Erklären Sie den Ansatz des Papers und versuchen Sie zu erklären, was dies an Einsichten über DNNs bringt und warum (Anmerkung: Eher eine explorative Aufgabe; mir ist es nicht wirklich klar geworden.)

Praktische / weiterführende Aufgabe: Man kann versuchen, die Visualisierungen selbst zu berechnen. Eine theoretische(re) Erklärung dazu, wie das ganze zu interpretieren ist, wäre aber auch sehr wertvoll.

Level: Bachelor/Master

Gebiete: DL

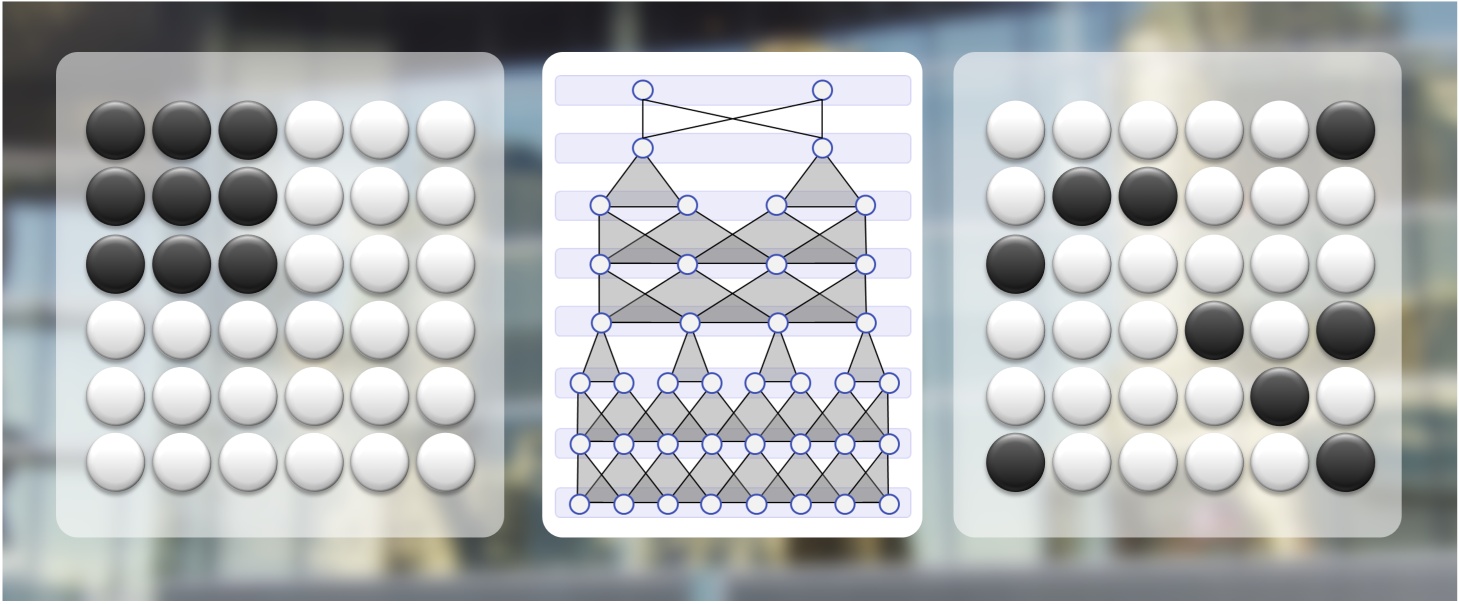

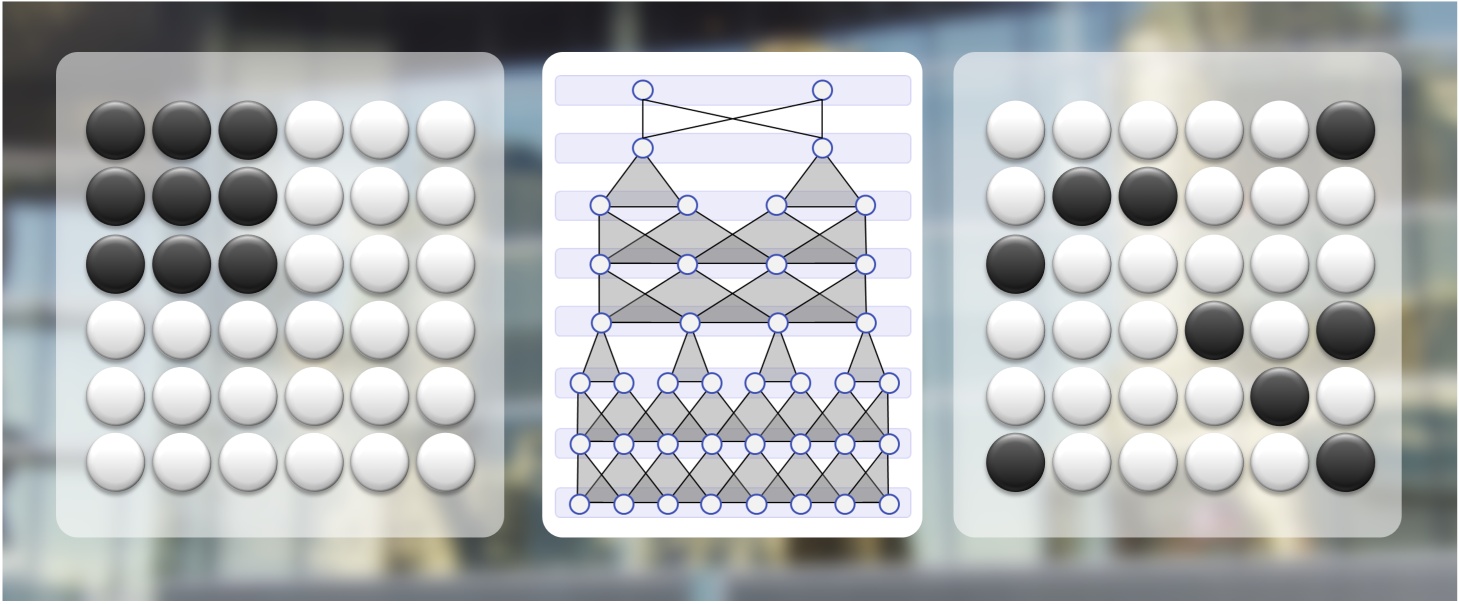

Die Topologie der Loss-Landschaft eines tiefen Netzes ist interessant – die lokalen Minima sind dabei durch Pfade mit guter Performance verbunden.

Quelle:

Aufgabe (Seminar): Erklären Sie Ideen und Ergebnisse des angegebenen Papers.

Praktische Aufgabe: Versuchen Sie, 2D-Schnitte aus der Loss-Landschaft eines (sehr viel höherdimensionalen) DNNs zu visualisieren (mit z.B. mit Python-Plot-Bibliotheken wie MatPlotLib, dabei z.B. Dichteplots oder Höhenfelder nutzen). Vorschlag: Vergleichen Sie z.B. Netzwerke mit/ohne BatchNorm oder mit/ohne Residual-Connections. Die Mode-Connectivity wird man hier aber wohl nicht sehen (nicht nötig für die prakt. Aufg.).

Level: Bachelor/Master (eher fortgeschritten)

Gebiete: DL

Dieses Paper zeigt Anhaltspunkte dafür, dass sich die Prior-Distribution eines tiefen Netzwerkes direkt über die Initialisierungsverteilung charakterisieren lässt. Meiner Meinung nach eines der interessantesten Papers der letzten Jahre.

Quelle:

Aufgabe (Seminar): Erklären Sie die wichtigsten Einsichten des Papers.

“Praktische” Aufgabe: Hier ein Vorschlag für eine “experimentelle” Ergänzung, die kreativ aber trotzdem eher theoretisch ist: Überlegen Sie sich, warum es nicht so einfach ist, die Hypothese (Initialisierungsverteilung ist “der Prior”) experimentell zu validieren. Was macht dieses Paper (statt dessen), und warum ist das möglich? Fallen Ihnen andere Ansätze ein (keine einfache Frage)! Diskutieren Sie dies in Ihrer Ausarbeitung.

Level: Bachelor/Master (eher fortgeschritten)

Gebiete: DL

Dieses Paper ist eine Fortsetzung von Thema 6, und ebenfalls super-spannend. Komplementär zum Vorgänger wird eine Verbindung zwischen “einfachen Funktionen” und dem Initialization Prior hergestellt. Auch super interessant :-).

Quelle:

Aufgabe (Seminar): Erklären Sie die wichtigsten Einsichten des Papers.

“Praktische” Aufgabe: Siehe Thema 6. Warum ist es schwierig, die Prior Distribution von Netzwerken direkt zu “messen”? Diskutieren Sie die Probleme in Ihrer Ausarbeitung. Was wird hier (statt dessen) gemacht?

Level: Bachelor/Master (eher fortgeschritten)

Gebiete: DL

Dies Paper zeigt, das das Double-Descent Phänomen verschwindet, wenn man Model-Averaging betreibt. Schon etwas älter, aber sehr interessant.

Quelle:

Aufgabe (Seminar): Erklären Sie die wichtigsten Einsichten des Papers.

Praktische Aufgabe: (erfordert eine gute Graphikkarte und Erfahrung mit DL) Bauen Sie ein einfaches Toy-Netzwerk und trainieren Sie es auf einem Datensatz wie MNIST oder CIFAR-10 mehrmals bei verschiedener Breite (z.B. 2,4,8,16,32,64,128,256…). Können Sie das Double-Descent Phänomen beobachten? Optional: Falls ja, und Ihre GPU wirklich stark ist, wird es schwächer, wenn man immer 10 zufällige Modelle mittelt?

Level: Bachelor/Master (eher Master)

Gebiete: Mod-1

Das Paper benutzt quadratische Optimierung, wie wir es in Modellierung 1 viel diskutiert haben, um in der Bildverarbeitung Vordergrund von Hintergrund zu trennen.

Quelle:

Aufgabe (Seminar): Erklären Sie, wie die Methode funktioniert und berichten Sie über die Ergebnisse.

Praktische Aufgabe: Code ist verfügbar. Falls Sie lieber selbst kreativ werden möchten, versuchen Sie sich mal an einer naiven Implementation des Problems (Thresholding, Nearest-Neighbor-Color-matching o.ä.). Wie gut oder schlecht sind solche “Base-Line”-Ergebnisse (im Vergleich)?

Level: Bachelor/Master

Gebiete: Mod-1

Dieses Paper präsentiert eine linearisierte Deformationsenergie, mit der man (z.B.) Triangle-Meshes in der Computer-Graphik editieren kann. Dies ist die historisch frühere, aber eigentlich kompliziertere Version (siehe auch Thema 11). Älter, aber ein Klassiker.

Quelle:

Aufgabe (Seminar): Erklären Sie, wie die Methode funktioniert und berichten Sie über die Ergebnisse.

Praktische Aufgabe: Es gibt wohl Code dazu; falls es hier Probleme gibt, kann man verschiedene Mesh-Deformation Methoden auf dem Stanford-Bunny Vergleichen.

Level: Bachelor/Master

Gebiete: Mod-1

Dieses Paper präsentiert auch eine linearisierte Deformationsenergie, mit der man (z.B.) Triangle-Meshes in der Computer-Graphik editieren kann. Dies ist historisch später als die Methode aus Thema 10, aber so einfach zu verstehen und implementieren, dass sie heute überall benutzt wird. Alt, aber ein Klassiker.

Quelle:

Aufgabe (Seminar): Erklären Sie, wie die Methode funktioniert und berichten Sie über die Ergebnisse.

Praktische Aufgabe: Auch hier gibt wohl Code dazu; falls es hier Probleme gibt, kann man verschiedene Mesh-Deformation Methoden auf dem Stanford-Bunny Vergleichen.

Level: Bachelor/Master

Gebiete: 2D-CV

Ein junger Klassiker: Co-Einbettung von Bildern und Text lernen. Solche Sachen benutzen diverse Bildgeneratoren und Multi-Modale Foundation Models.

Quelle:

Aufgabe (Seminar): Erklären Sie die Grundidee, wie diese in dem konkreten Modell umgesetzt wurde. Gehen Sie auch auf die Ergebnisse ein.

Praktische Aufgabe: Code ist verfügbar. Die kleineren Varianten sollten auch auf Consumer-GPUs (oder im CPU-Modus) laufen (ich habe es aber nicht selbst getestet; ggf. ein alternatives Modell suchen).

Level: Bachelor/Master

Gebiete: 2D-CV

Ein etwas älterer (aber immer noch jung, so als Urgroßelternteil) Klassiker: Co-Einbettung von Bildern und Textuellen Labels lernen. Solche Sachen benutzen diverse Bildgeneratoren und Multi-Modale Foundation Models, nur mit schickeren Methoden (statt der hier verwendeten linearen SVM).

Quelle:

Aufgabe (Seminar): Erklären Sie auch hier die Grundidee, und wie diese formal umgesetzt wird.

Praktische Aufgabe: Ich bin mir nicht sicher, ob man für eine solche Methode Code finden kann. Aber man kann mal die Ergebnisse aus dem Paper mit denen von CLIP oder ähnlichen modernen Methoden vergleichen.

Level: Bachelor/Master

Gebiete: 2D-CV (Mod-1; vielleicht auch Mod-1 bei Vorkenntnisse in Deep-Learning)

Auch ein interessantes Paper: Wie kann man Aliasing aus generierten Bildern heraushalten? Hier für GANs umgesetzt. Spoiler: Signaltheorie/Fourier-Magic.

Aufgabe (Seminar): Erklären Sie die Kernideen des Papers (vor allem mit Fokus auf das Vermeiden von Aliasing Artefakten, weniger auf die Umsetzung der GANs)

Praktische Aufgabe: Auch hier ist Code verfügbar.

Ein “neural field” ist eine Funktion, die direkt als Netzwerk dargestellt wird. Dazu gibt man ihr Koordinaten als Eingabe, und die Funktion spuckt direkt die Funktionswerte aus. Typischerweise ist die Eingabe niedrig-dimensional (1D/2D/3D, ggf. via “positional encoding” dargestellt) und die Ausgabe sind z.B. Farben eines Bildes oder die Dichte eines Faltungskerns für ein CNN. Das Netzwerk ist typischerweise ein einfaches “fully-connected” Netzwerk (auch “MLP, multi-layer-perceptron” genannt) mit mehreren Schichten.

In dieser Aufgabe soll nun ein Photo als FCN/MLP kodiert werden. Wählen Sie dazu eine geeignete Architektur (dies kann auch ein sehr kleines Netzwerk mit 1-2 Schichten sein, falls Sie keine GPU-Unterstützung haben) und “overfitten” Sie das Netzwerk gegen ein Bild (s/w oder Farbe) Ihrer Wahl. Bei geringen Ressourcen können Sie ein Bild niedriger Auflösung wählen. Visualisieren Sie dann das Approximationsergebnis als Bild und werten Sie insbesondere auch das Bild in höherer Auflösung aus.

Anregungen für weitere Experimente (optional):