Michael Wand, Institut für Informatik,

April 2021

Eine kurze Reise durch die Welt der statistischen Modellierung

Eine (noch unvollständige) Wiederholung der Konzepte der Vorlesung Modellierung 2

Dieses Dokument fasst einige der Themen der Vorlesung Modellierung 2 nochmal in Textform zusammen. Es erhebt keinen Anspruch auf Vollständigkeit und ersetzt nicht die Vorlesung selbst.

Noch ein Wort zum Konzept: Ziel der Vorlesung wie auch dieses Aufschriebs ist eine informelle, übersichtsartige Einführung in die Konzepte der statistischen Datenmodellierung. Ziel ist es, typische Probleme im Visual Computing (Graphik, Computer Vision) lösen zu können. Es besteht aber kein hoher Anspruch an mathematische Strenge und Präzision. Hier empfehle ich auf jeden Fall eine Vertiefung mit einer Fachvorlesung aus der Mathematik oder statistischen Physik.

Nun viel Spaßt beim Lesen.

Themen

tl;dr – Worum geht’s und warum?

Skript: Hier geht es zum Vorwort

Themen

tl;dr – Sokrates glaubt an nix. Die anderen machen Statistik, in verschiedenem Grade.

Skript: Hier geht es zu Kapitel 1

Themen

tl;dr – Unsicherheit mathematisch = Dichte auf einem Gebiet

Skript: Hier geht es zu Kapitel 2

Themen

tl;dr – Alle wirklich wichtigen Fragen sind fundamental umstritten und damit Geschmackssache.

Skript: Hier geht es zu Kapitel 3

Themen

tl;dr – Alles ist Statistik, aber mit unterschiedlich vielen Parametern.

Skript: Hier geht es zu Kapitel 4

Themen:

tl;dr – Die Klassiker

Skript: Hier geht es zu Kapitel 5

Themen:

tl;dr – Nur reiner Zufall ist echte Information.

Skript: Hier geht es zu Kapitel 6

Themen:

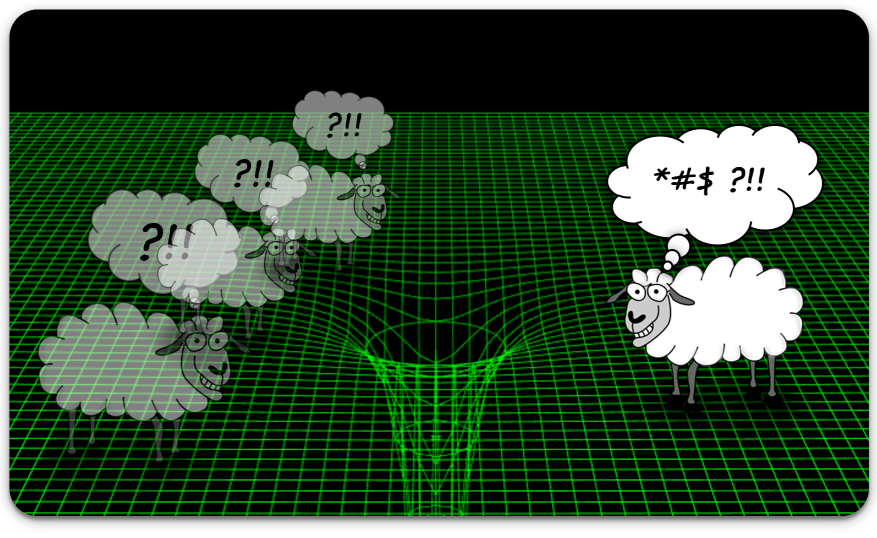

tl;dr – zu viele Parameter böse.

Skript: Hier geht es zu Kapitel 7

Achtung: Alles weiter unten ist noch vorläufig und kann sich jederzeit ändern. Die Webseite gibt den aktuellen Stand der Planung wieder und wird laufend aktualisiert.

Themen:

tl;dr – Modelle, die die Statistik vereinfachen, aber trotzdem nützlich sind

Skript: Hier geht es zu Kapitel 8

“Ich habe ein neutrales Netz (Akzent: Steiermark)”.

tl;dr – Wir haben keine Ahnung, wie Arnie funktioniert, aber er ist ziemlich cool.

Von BatchNorm über ResNets zu GANs und Transformers.

tl;dr – Man kann gut raten, wie man es machen muss. Es tut super. Aber ich weiss nicht warum.

Wir reiben uns verwundert die Augen und fragen uns, ob Kapitel 9 und 10 nicht Kapitel 1-8 fundamental widersprechen. Nein, tun sie nicht, aber es fühlt sich so an. Irgendetwas ist schief gelaufen. Versuchen wir zu verstehen, was das sein könnte.

Spoiler: Eine zufriedenstellende Antwort gibt es in dieser Vorlesung nicht mehr. Das sollte ja gerade der Grund sein, der sie interessant machen sollte.

Themen

tl;dr – Es war ein schöner Sommermorgen in Griechenland, ca. 600BC….

Skript: Hier geht es zu Kapitel 11

Themen

tl;dr – Alles MDS, also eigentlich, PCA

Skript: Hier geht es zu Kapitel 12

Informationsbottlenecks, disentanglement, etc.

tl;dr – umstritten

tl;dr – Gruppentherapie!

tl;dr – Ist alles ziemlich approximativ, aber die Formeln sind halbwegs impressive.

Es ist doch alles PCA: Fourier-Basis, Skaleninvarianz, Gruppentheorie, kritische Punkte

tl;dr – Wege ins Chaos

Overfitting ist anders als man Denkt. Training läuft anders als man denkt. Batch-Norm macht, was sie will. Spielen die Netze Lotto? Oder doch nicht?

tl;dr – “Jetzt haben wir zwei Systeme, die wir nicht verstehen”